很难否定伦理是由情感主导的,同样也难以否定主导伦理的情感必须是“交互”的,并不是独立于社会之外的情感。— David 9

前不久,谷歌AI伦理研究员工Timnit Gebru被辞退的风波发酵,但在David看来这和普通的不平等事件相似,没有必要加上“AI”的名头,况且目前的AI没有能力和动机去歧视人类(或一部分人类),只有一部分人类去歧视另一部分人类的可能。

并且,谷歌的一些人事和项目的弥补,只是隔靴搔痒,和大多数其他AI伦理项目一样,只是审查工具和人员调动(梵蒂冈AI伦理计划和联合国的AI伦理委员会)。但,真正把主动权交给AI的——所谓“通用人工伦理”的研究却相当少,而这,我认为并不是不可能(至少某种程度上)。在走向通用AI伦理的道路上,david认为这些问题更值得思考:

情感——重要因素

善与恶的知识不是别的,而是我们所意识到的快乐与痛苦的情感 —— 斯宾诺莎

如果大多数人在情感上无法接受,很难说伦理上是正确的。

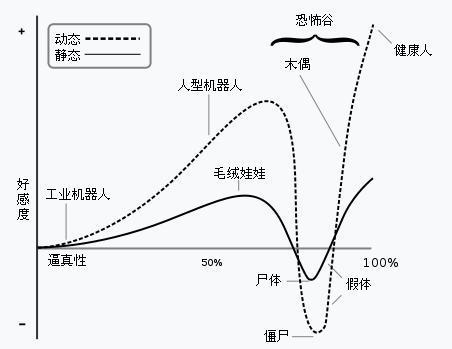

许多学者认为伦理(善和恶的区分)是人意识到的情感。认知神经科学家也认为,道德判断两个重要组成就是:有意识的认知推理过程(理性)和情绪启动的直觉(情感)过程。而前者似乎只是判断事情真相,后者才左右普遍的看法。如恐怖谷理论认为,当机器人与人类的相似程度达到一个特定程度的时候,人们会(对任何瑕疵)突然变得极其负面和反感,

而反对者认为,这种情绪在人与人的接触中也会出现。

无论如何,这种刻在我们基因中的