我们在第一部分讨论胶囊网络时提到过神经网络(cnn)对纹理很敏感,而不够关心位置和形状信息,这里是David收集的更多的讨论和参考文献,希望对你们有帮助:

1. 研究人员证明神经网络的物体检测有多脆弱,以及一些对抗样本例子:Machine Learning Confronts the Elephant in the Room

2. 实验证明数据增强不能把神经网络的泛化能力提高到人类的水平:Generalisation in humans and deep neural networks

3. 一些非常相似的图片足以迷惑神经网络, 继续阅读为什么神经网络(cnn)关心纹理,而不关心位置和形状信息?整理一些解释和参考文献

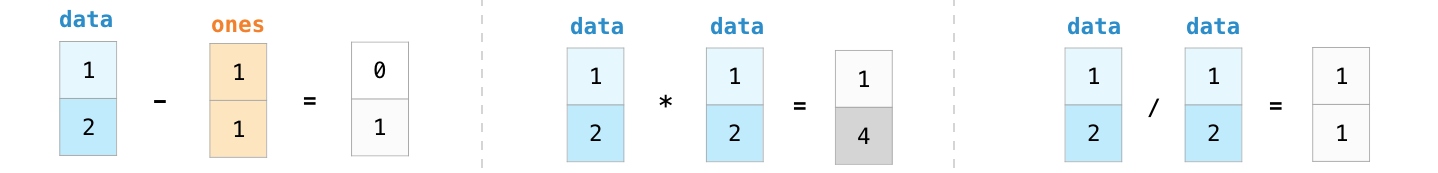

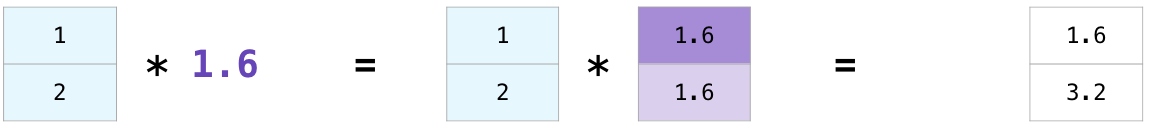

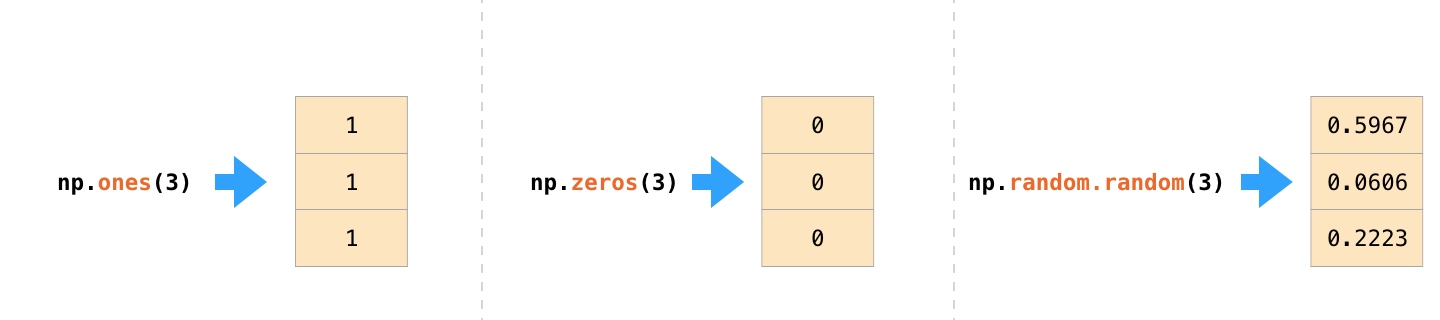

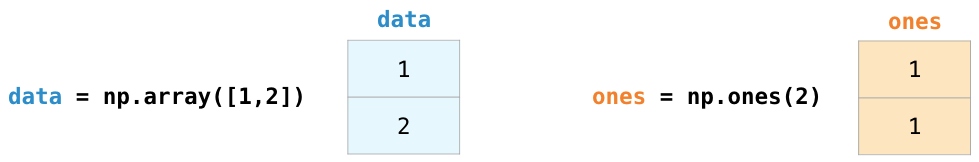

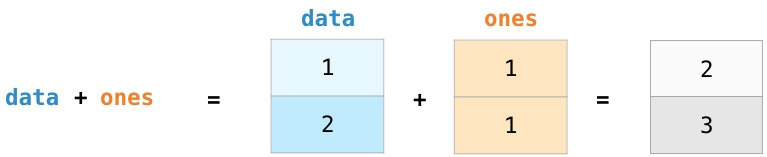

不仅仅可以进行加法操作,还可以进行其他的运算:

不仅仅可以进行加法操作,还可以进行其他的运算: