作为一个物种,人类智能(human intelligence)正在向通用智能(general intelligence)的方向发展,不是吗?— David 9

最近看到Yann LeCun 的播客访谈,聊到人类智能,LeCun认为人类智能是非常specific的(具体的而远非“通用智能”):

是的,为了在大自然长期生存下来,我们的祖先更关心与生存密切相关的东西。我们的视觉有盲区,行为有太多模式,我们的内在“世界模型”也不“通用”(general)。

人类经常以为自己能应对世界的复杂变化,这只是他们一厢情愿的世界观,事实上,多数情况他们只能勉强应对(在自己构建的“世界模型”的舒适区)。

但这,足以支撑普通人的正常生存(即使他们用自以为用完整通用的智能应对一切), 原始人主要任务是擅长打猎就行(其他的复杂因素如天气可以用“神”来补充世界观):

工业时代为了生存,人类甚至可能沦为机器的奴隶:

所以,

与其说人类是通用智能,不如说我们是基于生存的智能 — David 9

David同意人类的局限是明显的,但借助外部工具如AI,人类正在变得越来越general,看到很多看不到的东西,这种人与机器的“互补智能”是未来不可估量的(有机会下次展开)。拉回到主题:

人类智能本身, 其实也有一个秘密武器:”自监督”学习。

那么究竟什么是自监督?

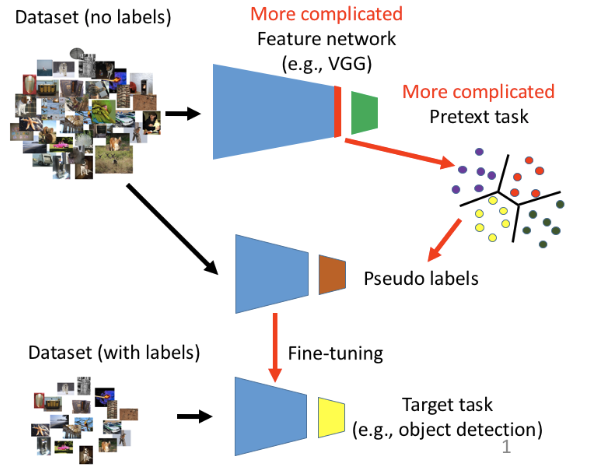

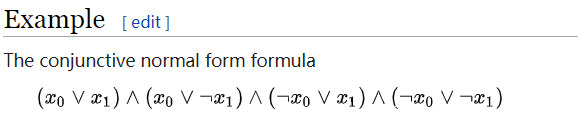

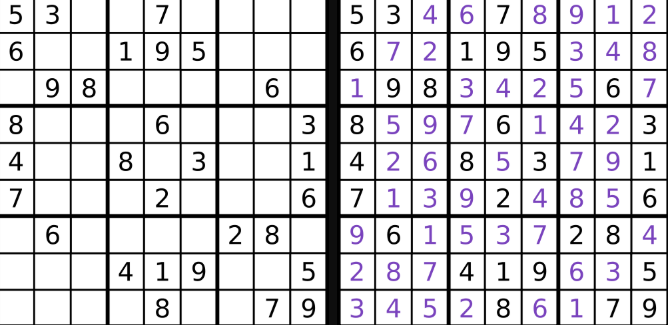

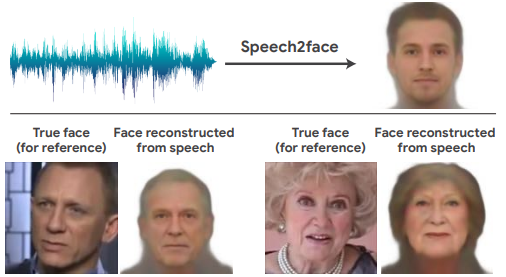

首先,自监督是有监督学习!哪怕目前缺少有标注的samples,他也会想办法加上一些假的(pseudo)label ,或者用其他间接的方式得到比较可信的label。其次, 继续阅读【独家】深入了解自监督学习(self-supervised learning),David 9的番外篇