艺术不仅是“压缩”的艺术。如果艺术是“做菜”,重要的不仅仅是厨艺,还有食材的选择,所以,艺术也是“选择”的艺术。 — David 9

Jürgen Schmidhuber教授的名字大家可能不熟悉,但如果说LSTM之父大家可能有点印象,事实上他也算人工智能的开创鼻祖之一。他与学术界和深度学习三巨头(Hinton、LeCun、Bengio)的恩怨纠葛David这里不多八卦,只给出【链接】。今天,David想深挖一下Schmidhuber曾经在90年代总结的“低复杂度美学”(艺术)理论,现在看来也很有意思并且启发我们。

“低复杂度美学”的原理和目标很简单:

1. 作品最终看上去是想要表达的内容,即,内容没有太大偏差。

2. 创造作品的柯氏复杂性应该做到最低。通俗地说就是,如果要用一段最短的程序完成整个艺术创作过程(在计算机中叫停机过程),这样就会体现出一定美感。

事实上,上述两者是矛盾的,如果太追求简洁,有可能会失去一部分你想表达的信息,反之,如果你想完整地表达所有信息,你可能会牺牲一些简洁性。

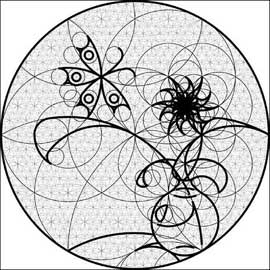

而对于第1点,艺术家想要传达什么,是非常主观的问题,所以Schmidhuber在讨论时把重点放在第2点,如果内容已经固定,艺术设计采用低复杂度美学是有效的。让我们看一个例子:

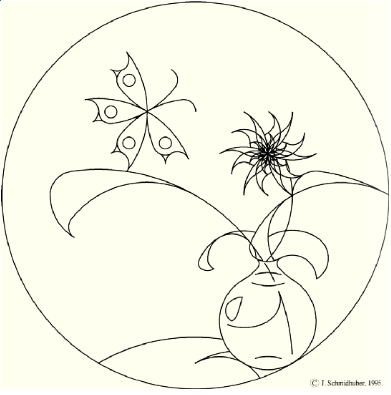

如果你要画一个花瓶和蝴蝶,大致构图已经想好,那么如果让一个程序完成创作,让它不断地画圆弧是个好主意(代码简短容易实现),另外如果加一些简单规则也很容易(比如圆弧和圆弧的交点可以衍生出圆心再画一个圆弧,可以有同时切两个圆的圆等等……),根据这些简单规则,我们就可以用一个足够简洁的程序生成如下作品:

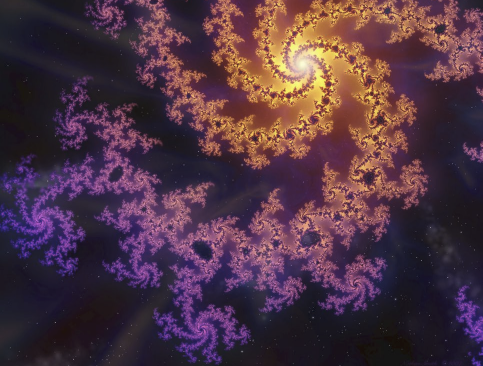

这和我们熟悉的分形几何美感原理类似:

这种“低复杂度美学”理论可以衍生出许多其他相关见解, 继续阅读“低复杂度美学”理论(Low-Complexity Art):艺术,科学,创造力和美学启示 #David的人工智能启示录