宇宙没有义务让人理解,但AI有义务被人,并帮助人理解! —— David 9

一个AI模型,无论被工程师如何设计,它最终还是要和使用者交互,哪怕只是一个小小简单的判断分类问题。一旦它把判断结果信息传递给人类,人与机器之间的边界就变的难以划分。AI判断结果一定有错误信息(或AI够不着的问题),人类应该怎么处置?

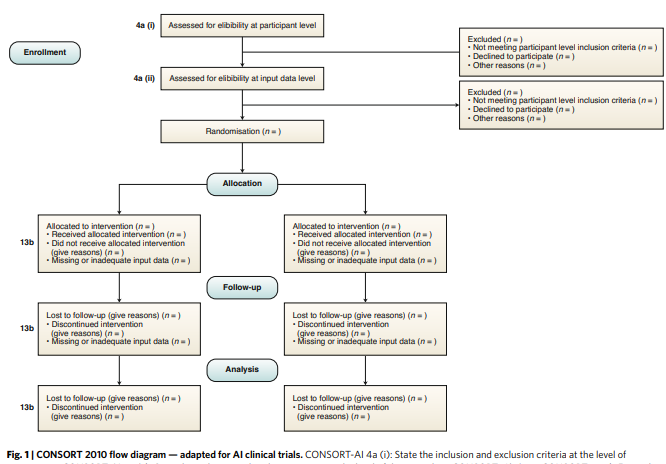

当然,后一种更容易操作,把AI够不着的问题都留给人类解决,如医疗领域的SPIRIT-AI和CONSORT-AI协议,就旨在提供一套完善的医疗实验交互方针:

因为医疗临床实验需要更高规范和更低出错率。不仅仅是医疗,事实上,目前的多数领域的AI落地,交互,都需要大量的人力处理。

David不反对这种做法,因为即使