虽然ICLR2018将在今年5月召开,但是双盲评审已经如火如荼。目前评审结果排位第一的论文试图解决神经网络在预测分布上缺乏鲁棒性的问题。

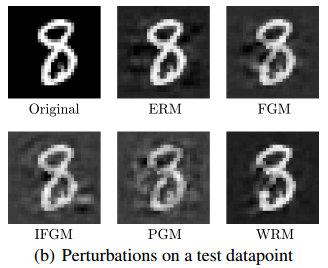

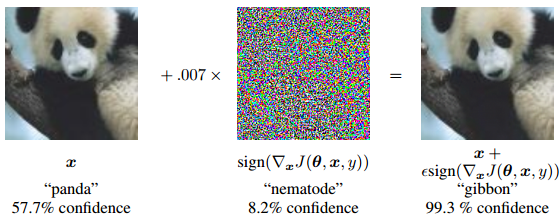

我们都知道神经网络和人一样也有判断“盲点”。早在2015年Ian Goodfellow 就提出了攻击神经网络的简单方式,把cost函数 J(θ, x, y)对输入图片x求导,得到一个对神经网络来说loss下降最快的干扰噪声:

一旦加入这个细微噪声(乘以0.007),图片的分错率就达到了99.3% !

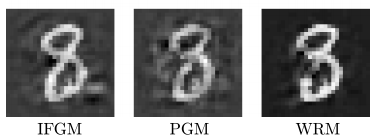

这种生成对抗样本的攻击方法被称为FGM(fast-gradient method快速梯度法),当然还有许多攻击方法, 下面是对数字8的测试攻击样例:

有了攻击方法我们就能增加神经网络的鲁棒性, 那么FGM是加强模型鲁棒性的最好参考吗?

该论文的答案是:NO !

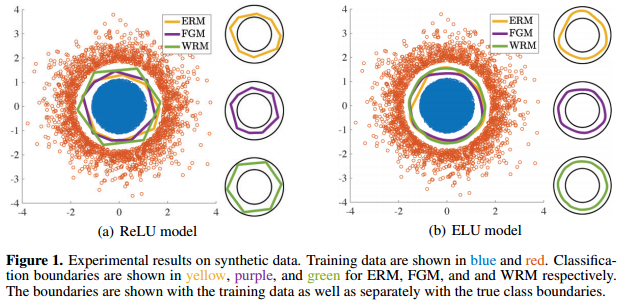

论文提出了Wasserstein鲁棒更新方法WRM,文章指出,通过WRM训练出的模型有更鲁棒的训练边界,下面是David 9最喜欢的论文实验图:

杰出的论文不仅应该有实用的方法,更应该有让人豁然开朗的理论,不是吗?

上图Figure 1是一个研究分类边界的人工实验,蓝色的样本点和红色的样本点是两类均匀样本,因为蓝色样本比红色样本多得多,所以分类边界倾向于向“外”推。ERM,FGM,WRM是通过三种对抗样本生成方式,更新和优化模型决策边界的效果。

Figure 1告诉我们 3个重要信息:

1. 决策边界中,越是有棱角,越是说明模型决策存在敏感的漏洞(如上面提到的FGM攻击),越是圆滑越说明模型的被攻击的漏洞越少。

2. 即使用同样的更新方法(如FGM), 用不同激活函数ReLU和ELU会有较大的边界差别. 很明显, 光滑的ELU函数较ReLU函数在各个方向上有WRM更好的鲁棒性 . 还记得我们写过的GAN代码吗 ? 较强的判别器用了光滑的tanh激活函数, 也是为了有更强的判别能力.

3. 该论文提出的WRM方法在ELU下有最好的鲁棒性边界.

那么究竟WRM比FGM等攻击有什么优势呢 ? ? 从WRM背后的理论可以看出, WRM并不是像FGM随意地求梯度.

我们首要目的是找到一个数据分布z’,能够最大限度地增加模型的鲁棒性。文章不仅考虑了让模型有最大loss,而且还考虑了让数据扰动的程度最小:

其中l是模型θ在扰动后数据z’上的loss,c(z’,z0) 是从原始数据分布到扰动数据分布变化的cost值(文章使用的是Wasserstein距离)。cost越大,扰动的成本越大。所以最终目标找到z’, 使得上式的值最大。这样的扰动数据z’, 不仅使模型loss最大,而且还用最小的cost扰动原始数据。其中γ是惩罚因子,惩罚越大, 找到的z’的扰动越保守,鲁棒性更差。

其中l是模型θ在扰动后数据z’上的loss,c(z’,z0) 是从原始数据分布到扰动数据分布变化的cost值(文章使用的是Wasserstein距离)。cost越大,扰动的成本越大。所以最终目标找到z’, 使得上式的值最大。这样的扰动数据z’, 不仅使模型loss最大,而且还用最小的cost扰动原始数据。其中γ是惩罚因子,惩罚越大, 找到的z’的扰动越保守,鲁棒性更差。

事实上,上式可以展开为泰勒级数:

注意到最后那一项二阶展开,如果这个二阶项是负的:

(并且z是光滑的)那么整个式子就可以保证是一个凸优化问题,我们就能快速计算出z’的最佳值。当然前提是惩罚因子γ足够大(不要太大)。

如果你不记得这个二阶项为何这么重要,可以回忆一下泰勒公式:

总之,有了这样的理论支撑,Wasserstein鲁棒更新方法WRM算法就变得容易理解了:

在对抗训练中,我们每次迭代中用上面的方法找到那个![]() , 用来更新模型参数θ。

, 用来更新模型参数θ。

最后David 9想讲一下 Wasserstein距离,我们都知道 Wasserstein距离是度量分布与分布之间距离的。那么Wasserstein距离究竟是如何计算的?这里我们稍微展开一下,更通俗的名字叫Earth Mover’s Distance, 为什么叫推土距离?

大家看过推土机吗:

如果蓝翔技校老师让你把下面左边Pr分布土堆, 变成右边Pθ土堆:

如果蓝翔技校老师让你把下面左边Pr分布土堆, 变成右边Pθ土堆:

你一定会用找最省力的方案吧 ? EMD(Earth Mover’s Distance) 推土距离就是最省力方案下的推土成本.

事实上EMD求的是一个最优化的Pr, Pθ的联合分布, 即最省力的方案.

具体算法大家可以看看这篇很棒的博客: Wasserstein GAN and the Kantorovich-Rubinstein Duality, David 9也在考虑下次扒一扒EMD算法,

敬请期待…

2018年4月16日更新

这篇论文(https://openreview.net/pdf?id=Hk6kPgZA-)是出自斯坦福大学,ICML 2018 accepted papers 已经放出:、

https://iclr.cc/Conferences/2018/Schedule?type=Poster

参考文献:

- https://openreview.net/pdf?id=Hk6kPgZA-

- http://search.iclr2018.smerity.com/

- https://baike.baidu.com/item/%E6%B3%B0%E5%8B%92%E5%85%AC%E5%BC%8F

- https://vincentherrmann.github.io/blog/wasserstein/

- https://en.wikipedia.org/wiki/Wasserstein_metric

本文采用署名 – 非商业性使用 – 禁止演绎 3.0 中国大陆许可协议进行许可。著作权属于“David 9的博客”原创,如需转载,请联系微信: david9ml,或邮箱:yanchao727@gmail.com

或直接扫二维码:

David 9

Latest posts by David 9 (see all)

- 修订特征已经变得切实可行, “特征矫正工程”是否会成为潮流? - 27 3 月, 2024

- 量子计算系列#2 : 量子机器学习与量子深度学习补充资料,QML,QeML,QaML - 29 2 月, 2024

- “现象意识”#2:用白盒的视角研究意识和大脑,会是什么景象?微意识,主体感,超心智,意识中层理论 - 16 2 月, 2024