这一弹,接着上一期,这次,我们要解释一种典型的机器学习算法——动态主题模型(Dynamic Topic Model)。

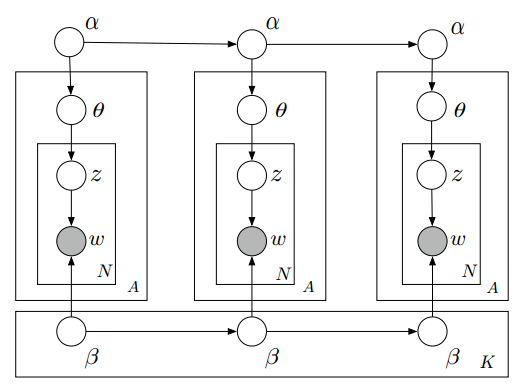

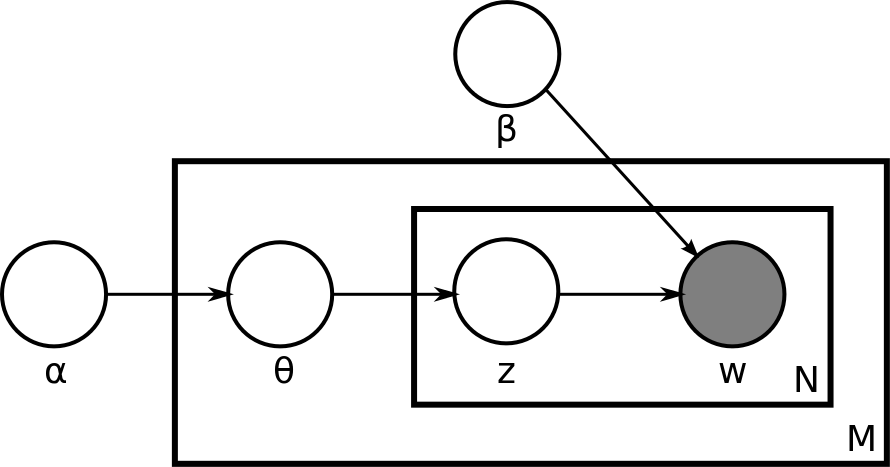

概率主题模型和概率图模型是每个做文本挖掘的学者的必学课题。其中最常见的主题模型是隐含狄利克雷分布(LDA)。当然,本文的动态主题模型也是主题模型的一种,不过为了方便理解,我们还是来回顾一下LDA。

我们定义:

α 是狄利克雷先验的参数,是每个文档可能的主题分布。

,当α 落实到一个文档m,

是文档m的主题模型。而且α代表的是狄利克雷分布,

代表的是多项式分布。 α很明显是

的共轭先验。

β 是狄利克雷先验的参数,但是,它是每个主题可能的文字分布。

是在文档m中,第n个文字的主题。 继续阅读卡内基梅隆大学(CMU),那些经受住时间考验的机器学习论文–第二弹:动态主题模型