如果性能遇到了瓶颈,“老套”的办法总能帮我们搞定一些事情 — David 9

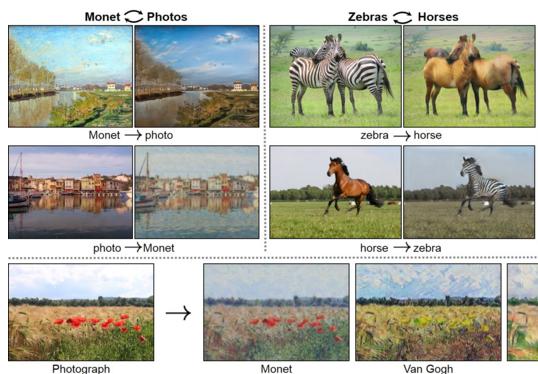

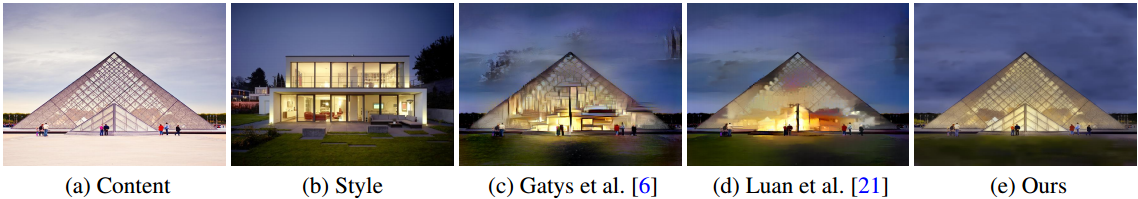

自深度卷积网络 广泛应用以来,我们更像进入了一个“伪智能”时代。深度网络的“创造”更多的是基于“巨量数据”的“创造”。以图片风格转换为例,无论是我们以前说的GAN还是其他变形CNN,都需要标注样本达到一定量,才能生成比较好的风格转换图(附带着冗长的训练时间 和其他模型调优技巧):

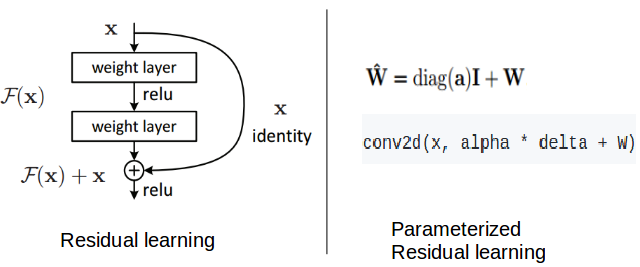

而英伟达前不久放出的CVPR新论文,一定程度上证明了在这个“伪智能”时代,只用深度网络是不够的,往往加入一些“老套”的算法可以帮你得到一些“漂亮”的结果:

上图是给定一张原始图片(a)和一张“黑夜”风格图片(b),我们希望把(a)的风格转换成(b)的结果。

可见(c)与(d)的结果都没有英伟达声称的方法(e)看起来自然。

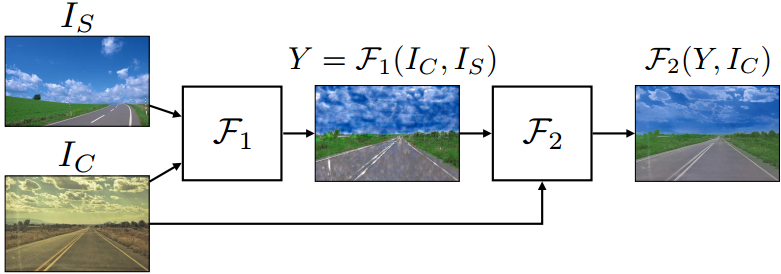

而英伟达这篇论文的一大半贡献不在深度网络,

而是如何把传统的WCT(白化和调色转换:whitening and coloring transforms)应用到深度网络中,以及图片平滑的后处理工作。

整体框架如下:

来自:https://arxiv.org/pdf/1802.06474.pdf 继续阅读“图片风格转换”又出新作,英伟达CVPR论文:高效图片风格转换与解析闭合解

来自:https://arxiv.org/pdf/1802.06474.pdf 继续阅读“图片风格转换”又出新作,英伟达CVPR论文:高效图片风格转换与解析闭合解