如果深度学习不是神经网络的终点, 那么神经网络会跟随人类进化多久? — David 9

自3年前Google收购DeepMind,这家来自英国伦敦的人工智能公司就一直站在神经网络与深度学习创新的风口浪尖(AlphaGo,DeepMind Health)。

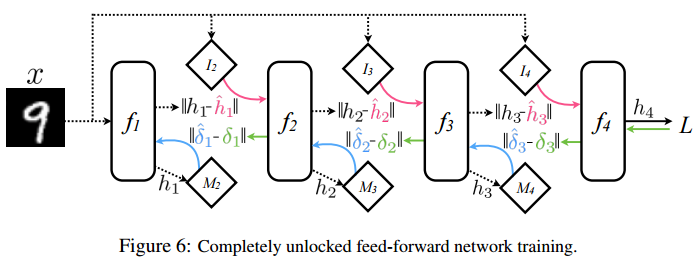

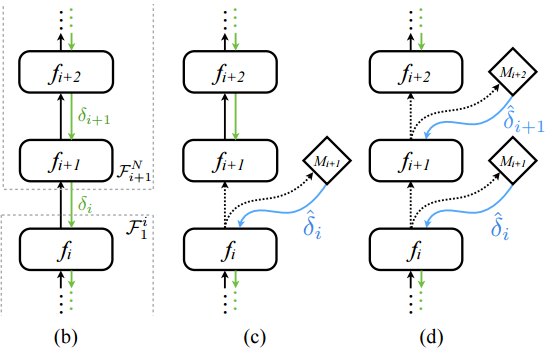

今天要介绍的“解耦神经网络接口”(Decoupled Neural Interfaces)的异步网络,就是出自DeepMind之手。这篇2016发表的论文试图打破传统的前向传播和后向传播按部就班的训练过程。在传统神经网络, 整个过程是非异步的更新,更新也是逐层紧耦合的(图b):

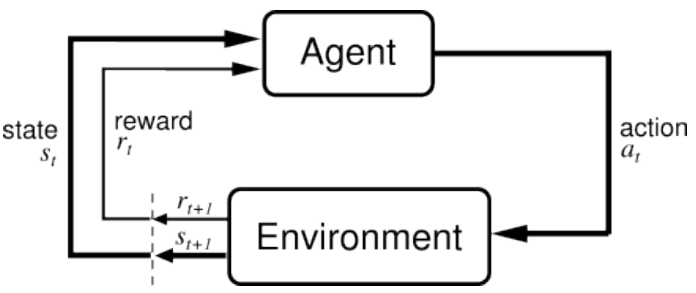

图(b)是传统普通前馈反馈神经网络(黑色是前馈箭头,绿色是反馈箭头),fi 层到fi+1 层的权重矩阵由fi+1层的偏导反馈δi 更新, 众所周知,反馈δi 必须等到后向反馈从输出层传递到fi+1 层后才能计算出。

为了试图解除这种“锁”(强耦合)(图(c)(d)),在(c)图中我们注意到在fi 层和fi+1 层之间,引入了模型Mi+1(图中菱形),又称人工“合成梯度”模型,用来模拟当前需要的梯度反馈更新。 继续阅读DeepMind新型神经网络:可异步训练的深度网络!— “解耦神经网络” 与 “合成梯度”