David 9 今天发现一篇很适合作神经网络101的文章, 就是这篇Learning How To Code Neural Networks . 没有什么比自己写一个简单的神经网络更容易理解神经网络的了.

所以, 让我们开始吧 :

步骤1: 神经元和前向传播

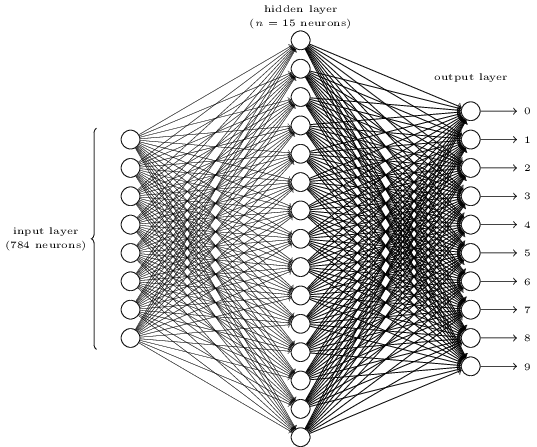

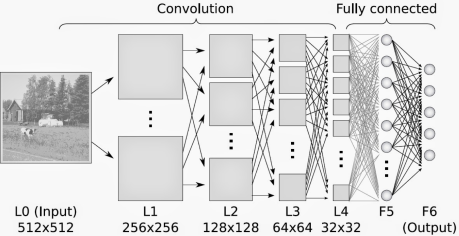

什么是神经网络? 我们首先要搞明白什么是神经元.

神经元像一个函数 ; 它输入一些值, 计算后, 仅输出一个值.

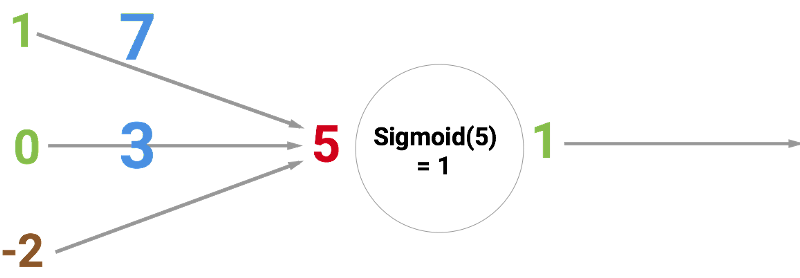

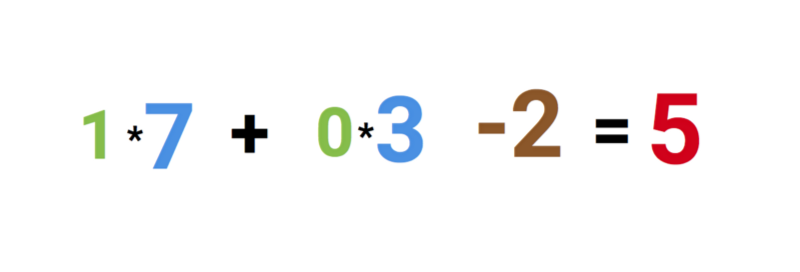

下图中, 是一个人工神经元,输入是5,经过Sigmoid函数输出是1. 输入值5是哪里来的呢? 其实就是向量[1, 0]与[7, 3]的点积, 最后加上bias偏置-2,即1*7 + 0*3 + (-2) = 5. 这里的[1, 0]叫输入向量,[7, 3]叫权重向量,-2叫偏置项,下面会谈到。

所以计算方式是: