特征工程的下一步可能是如何直接操控特征(同域或不同域),而不仅仅是特征选择或特征过滤 — David 9

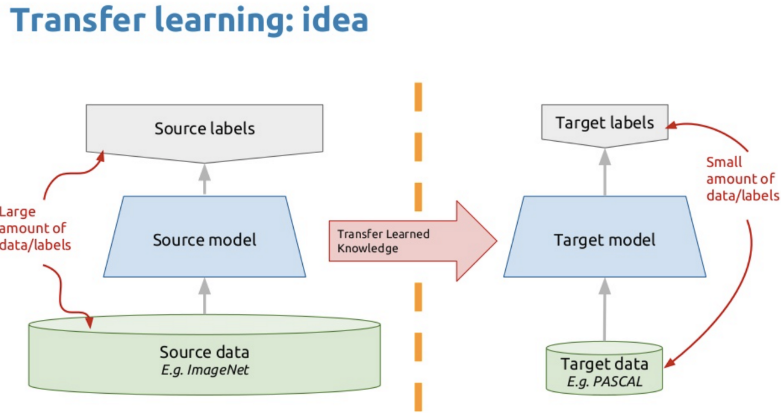

相信很多初学迁移学习的朋友心里一直有个疑问:迁移学习的模型真的对新应用效果也好吗?更好的迁移模型,在其他应用上表现效果也更好吗?

根据Google Brain在CVPR 2019的研究总结,今天David偷懒一次,只说结论:

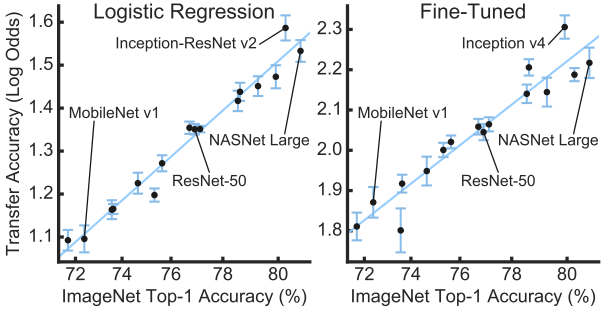

答案很大程度上是肯定的!Google Brain的大量实验证明,无论是把神经网络倒数第二层直接拿出来做预测,还是把预训练模型对新应用进行“二次训练”,好的imagenet预训练模型普遍有更好的迁移学习效果:

如上,左图是直接把网络倒数第二层特征直接拿出来进行迁移学习(使用Logistic Regression),右图是在新应用上find-tuned的迁移学习表现。可以注意到,只要是模型本来表现就好(横左标),迁移的效果就更好(纵坐标)。从性能最差的MobileNet到性能最好的Inception-ResNet无一例外。

但是,迁移学习并不是就无敌了。 继续阅读CVPR2019:好的模型,迁移学习效果就更好吗?Google Brain最新结论