我似乎看到了一个未来: 机器自身不断生成全新的模型架构, 去应对各种未知的问题. —— David 9

最近是个躁动的时节(ICLR 2017, Google I/O , Openstack峰会, 微软Build 等等), David 9也有点忙晚更了, 大家见谅. 今天, 接着拿ICLR 2017的一篇最佳论文, 这篇毁三观的论文实在是忍不住要拿出来讲一下. 论文来自Google 大脑团队:

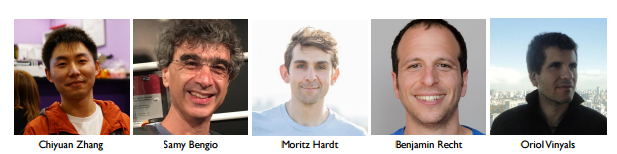

是不是看到了我们熟悉的Bengio? 但是 第一作者是MIT的实习生哦~ 是的, 其实这篇论文理论并不艰深, 亮点是实验方法和颠覆三观的结论. 探讨的是机器学习界古老的话题: 泛化能力.

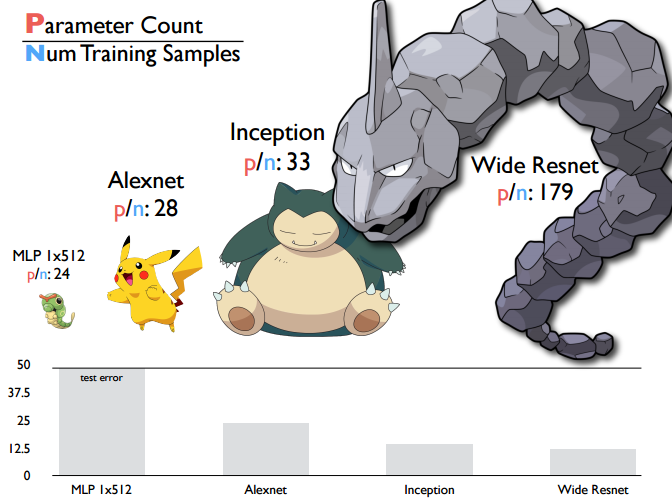

提到模型泛化能力, 人们一般的观念是VC维, 也就是模型越复杂(训练参数越多), 模型的泛化能力越差. 该文章用深度学习模型实验指出了这种错误观念, 事实上, 深度学习模型随着模型参数的增加, 模型依然具有一定泛化能力:

如上图, 对于一些经典深度学习网络, 我们用平均每个样本带有训练参数的数量来评价模型的复杂度, 继续阅读ICLR 2017论文精选#1之颠覆三观—理解深度学习要重新审视泛化能力(Best paper award 最佳论文奖)