如果训练神经网络可以与人一样,其训练日程可以精心规划编排、且有不同的学习曲线和阶段、在不同的领域有不同“天赋”自主学习。总之,训练过程可以足够“复杂”,是否可以诱导出更好的模型? — David 9

假设神经网络有一个确切的决策边界,这个决策边界足够复杂可以帮我们分类10000+个类别,想象一下可能是这样复杂的:

但无论如何,归结到一个决策边界,是这样的:

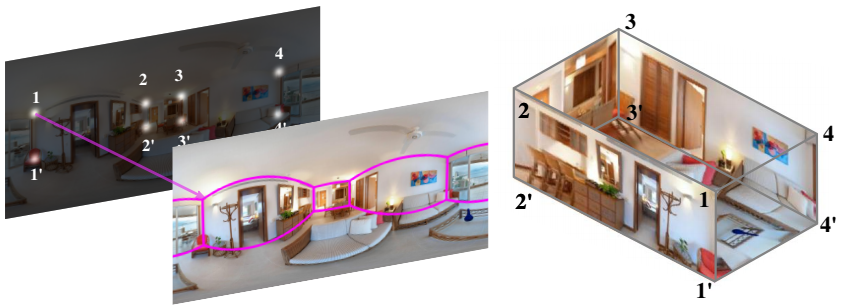

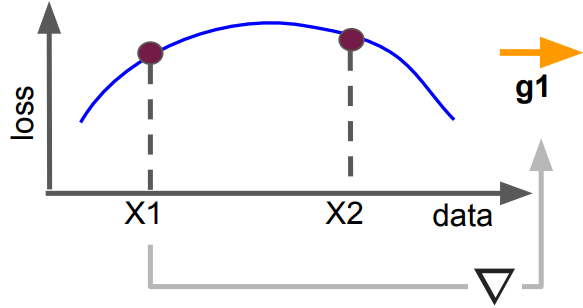

对于任意新的训练样本X1,如果要让X1的loss更小,需要用一个梯度g1更新网络,对决策边界的影响势必导致另一个新样本X2的loss可能变小、不变或变大:

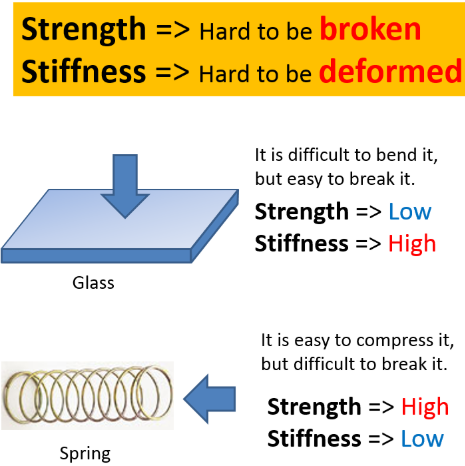

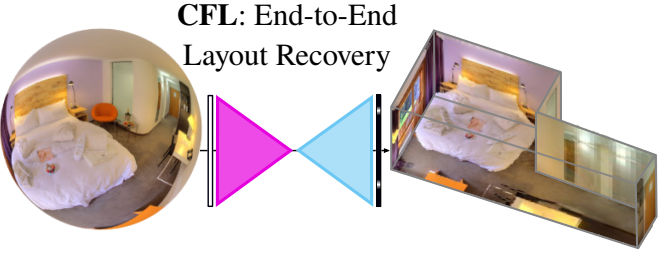

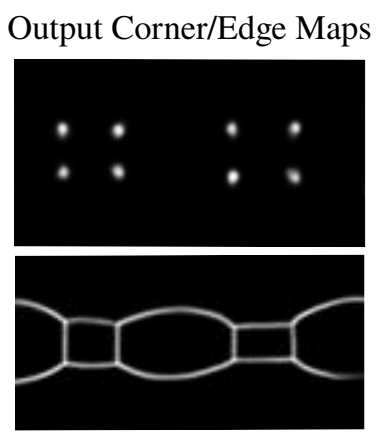

继续阅读神经网络的“刚性”(自恰性):谷歌评估泛化能力新指标,Stiffness