数据科学的可视化库和深度学习框架库一样,虽然层出不穷,但是大致分为两种:

一种是通用可视化库任何类似json schema的静态数据都可以用它作图如: Pandas, Seaborn , ggplot, Bokeh, pygal, Plotly 。

另一种是和框架耦合较高的可视化库,如TensorFlow的TensorBoard,scikit-learn增强可视化库Yellowbrick。

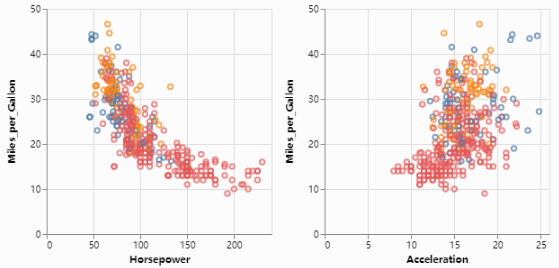

对于第一种通用库,方便简洁、易用的趋势一直没有改变。这届PyCon2018上的talk:Exploratory Data Visualization with Vega, Vega-Lite, and Altair 就介绍了Altair这种新的函数式编程可视化库,其简洁程度,只要拿到panda的dataframe数据,多加一句声明代码,就可以进行可视化了:

import altair as alt

# to use with Jupyter notebook (not JupyterLab) run the following

# alt.renderers.enable('notebook')

# load a simple dataset as a pandas DataFrame

from vega_datasets import data

cars = data.cars()

# 这里是声明代码,是不是有函数式编程的味道 ?

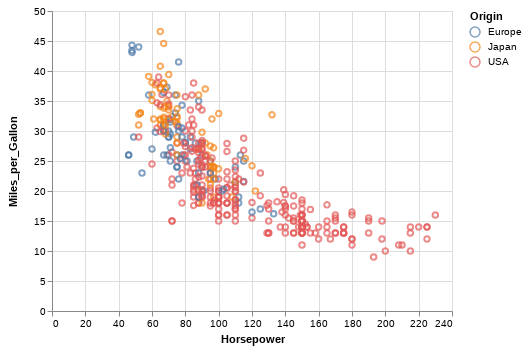

alt.Chart(cars).mark_point().encode(

x='Horsepower',

y='Miles_per_Gallon',

color='Origin',

)

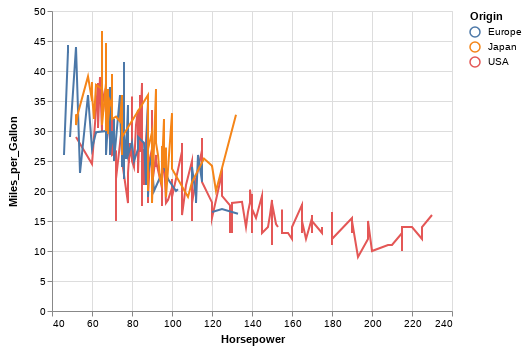

如果要把点的样式改成线的样式,只需把函数mark_point()改成mark_line()即可,如下代码:

alt.Chart(cars).mark_line().encode(

x='Horsepower',

y='Miles_per_Gallon',

color='Origin',

)

继续阅读#PyCon2018两款最新ML数据可视化库:Altair和Yellowbrick,函数式编程的可视化库和scikit-learn增强可视化库

继续阅读#PyCon2018两款最新ML数据可视化库:Altair和Yellowbrick,函数式编程的可视化库和scikit-learn增强可视化库