强人工智能(类人智能)可能比较遥远,但强数据控制智能已经临近 —— David 9

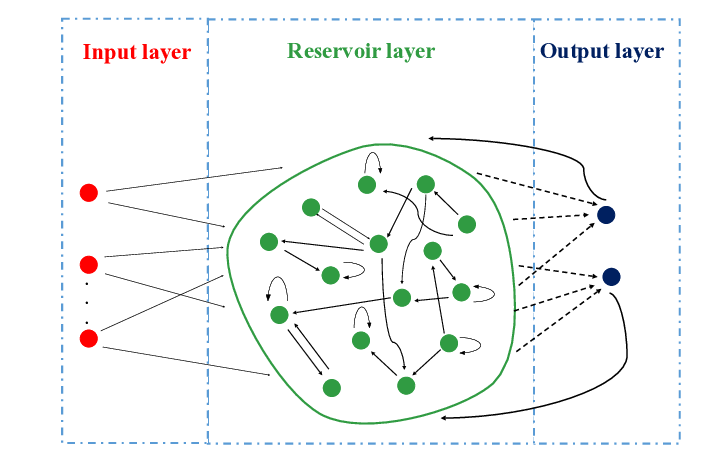

在上次感知融合中我们谈到,“肤浅感知”跳过了“理解” 这一步,不过,“肤浅感知”相当有效,以至于传统神经网络(CNN, RNN, BERT)可以直截了当地堆加融合数据(同态或多模态)。但是,很快人们就将发现问题:

1. “肤浅感知”模型太关注模型本身的优化,如特殊loss或特殊的优化器,而模型和当前数据集及任务是强相关的,这缺乏对数据的灵活控制和鲁棒性。

2. 正如阿德南曾在“是人类水平的智能,还是动物般的智能”中表达的,神经网络近年来在构造精巧的函数上是成功的,但进一步可以相信更精巧的函数还会出现,因为目前“动物智能”模型的精巧程度依旧比不上 动物。

更重要的是,也许我们低估了低等智能背后的普适性,越低等智能(感知),对于“外设”和输入数据越是鲁棒。如,盲人的听觉可以比常人好得多,跛脚的动物可以很快适应新的走路方式,我们用一只眼也可以很快地适应生活甚至做得更好,

低等感知需要做的是让输入信息更高效地流入自身的感知系统,并适应周围环境,这时的关键词是“快”,而不是“好”或“为什么”,只有人类才会在感知后还会有其他反思。

这就是为什么值得相信,目前的人工感知模型(cnn, transformers)在灵活性层面还有较大的提升空间。也许模型训练过程已经相当有效(高效),但数据处理上,可以说漏洞百出,除去平移旋转翻折等突兀的数据增强过程,仅仅“resize图像”这样一个操作,也可以放大灵活性并优化神经网络(见“Learning to Resize Images for Computer Vision Tasks”)。甚至可以大胆猜测: