看似庞大复杂的工程都来自一个简单的愿望 — David 9

人一生的行为往往由一个简单(但看似虚无)的意义驱动,而机器模型的行为由很多具体任务(实际的loss函数)驱动。于是,有的人为了“爱”可以苦费心思建成辉宏的泰姬陵 ; 而深度学习模型在不同任务间切换都如此困难。

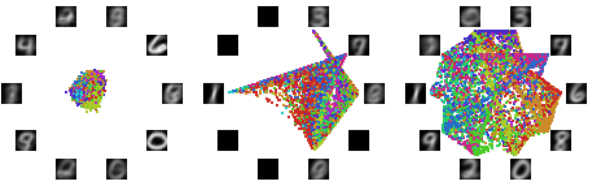

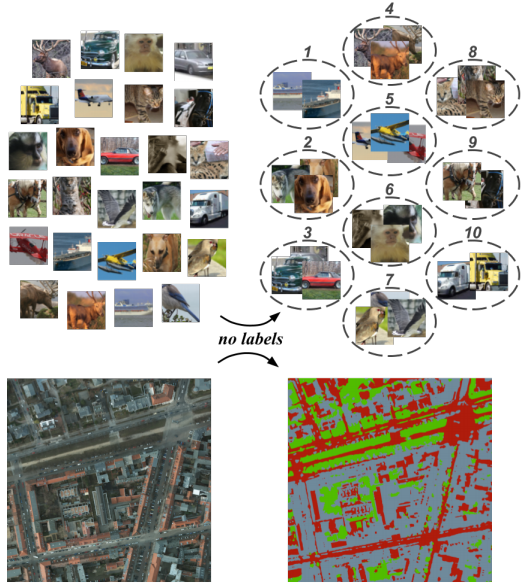

幸运的是,多数人的愿望是AI朝着更通用(非具体)的方向发展。所以我们可期待更通用AI模型的出现。甚至David期待将来“域”通用模型的出现,这里的domain指的至少是人体五官胜任的所有任务(视觉域,语言域,音频域,触觉域,嗅觉域等)

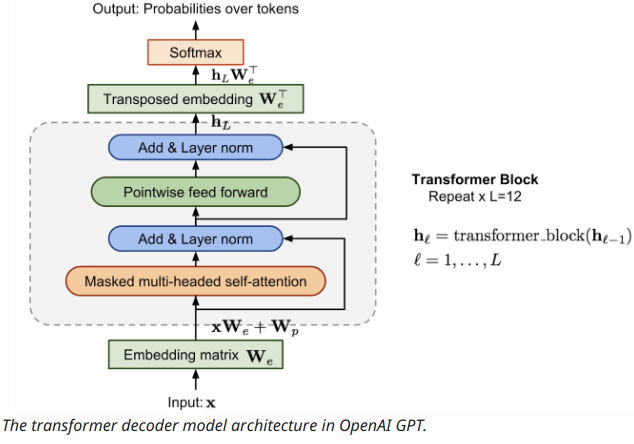

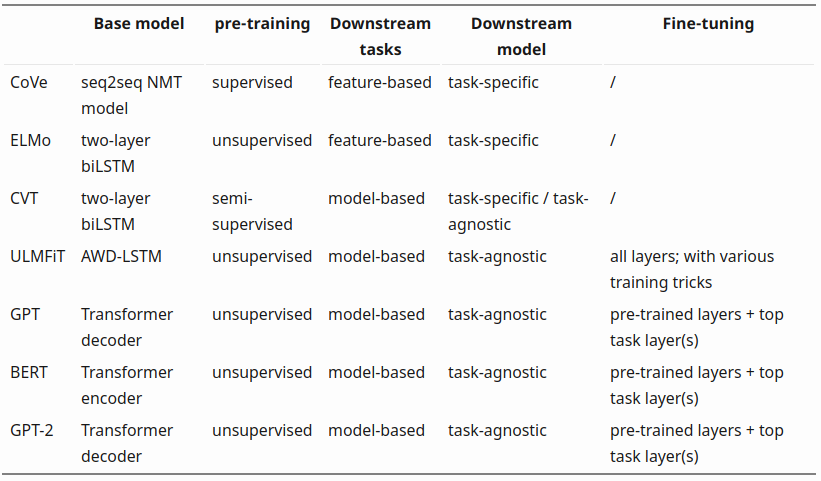

拉回现实,OpenAI在语言域的GPT(GPT-2)和音频域的MuseNet模型已经取得了广泛关注。对于通用语言模型的探索,GPT早已不是先例:

从汲取上下文关系的CoVe词向量(有监督,任务单一),到无监督预训练并且多任务通用的GPT-2 , 单模型“通用”的能力正在不断增强。

继续阅读一项无法忽视的无监督技术:OpenAI任务通用模型GPT,GPT-2,MuseNet,Attention 模型,#David 无监督系列