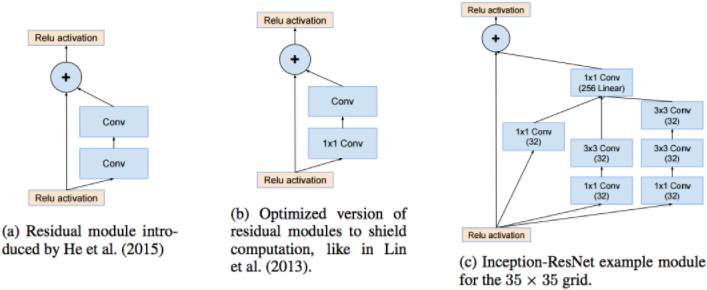

多融合和标准化的网络是深度架构未来的可见趋势 — David 9

Inception深度网络架构已经走过4个版本,AI的空前热潮,让业内期待新网络架构的心情如同当年期待Window系统版本一样。

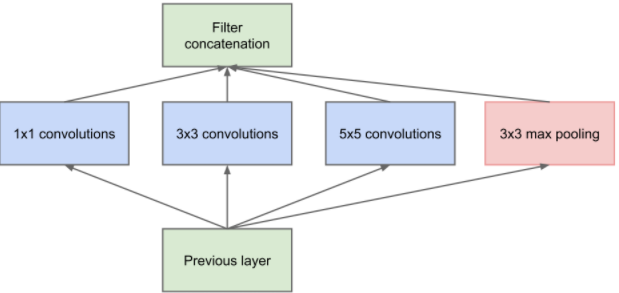

Inception V1的想法其实很简单:一方面我们人工地调整每层卷积窗口的尺寸(真麻烦!)另一方面,我们又想让深度网络更“深”,为什么不让同一层就有各种大小卷积可以学习?

是不是轻松多了?仅仅一层block就包含1*1卷积,3*3卷积,5*5卷积,3*3池化。

是不是轻松多了?仅仅一层block就包含1*1卷积,3*3卷积,5*5卷积,3*3池化。

这样,网络中每一层都能学习到“稀疏”或者“不稀疏”的特征:

1. 以前每一层线性卷积需要之后跟一个Relu激活函数或者pooling层增加非线性。而Inception V1直接通过DepthConcat在每个block后合成特征,获得非线性属性。 继续阅读#Inception深度网络家族盘点 | Inception v4 和Inception-ResNet未来走向何方 ?