与其说人类是智能“搜索”机,不如说人类是智能“贪婪”机— David 9

继续阅读ICLR 2020论文精选:“好奇心”的本质探讨,元学习与增强学习(RL)的“好奇心”机制,好奇心算法搜索,智能体的适应力增强

与其说人类是智能“搜索”机,不如说人类是智能“贪婪”机— David 9

继续阅读ICLR 2020论文精选:“好奇心”的本质探讨,元学习与增强学习(RL)的“好奇心”机制,好奇心算法搜索,智能体的适应力增强

如果“智能”是个体应对特定环境而被“诱导”出的,那么,个体的应对方式或作出假设的瞬间,也许是最有趣的部分! — David 9

David曾经讨论过Keras之父对智能的看法,也谈论过Yann LeCun对智能的看法。前不久Keras之父发起的因果推理语料(ARC)的kaggle竞赛结束,进一步激励我总结一下对“智能”的新看法。

首先,几乎一致认可的是,“智能”不仅是一个个基于任务的技能的简单集合这么简单。如果是这样,无法解释人类在一生中会学习自己都无法预料一些技能,我们学习未知技能的灵活性总是超出自己的想象。

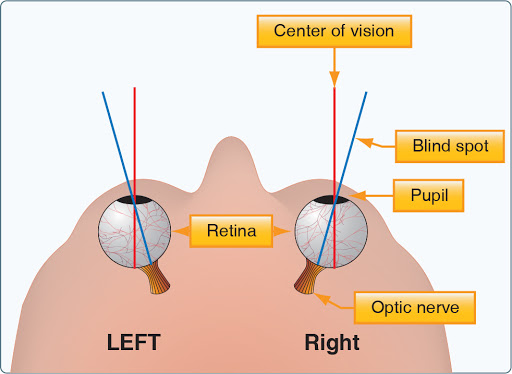

其次,人类智能也不是“通用智能”,这点François Chollet和Yann LeCun都提到了。如果人类智能是通用智能,那么无法解释人类根深蒂固不擅长的那些领域,如不擅长长期计划(跨域年的预测),视觉有盲区,认知有偏差,计算缓存小(多位数相乘就可以把我们难倒)等等。

哪怕经过训练我们也不能像熟悉走路一样自然地掌握线性代数。

同时,没有免费午餐定理告诉我们,任何优化方法,在一些方面的优势,在另一些方面则是劣势。因此,存在一个凌驾所有智能的万能的“通用智能”的可能性不大。稍加思考你还能发现“智能”这个东西是脱离不了外部环境的,它是大自然的产物。

那么人类智能究竟是一种什么样的“智能”?

人类使用工具的过程很有意思,他们用旧的“先验”去获取新“先验”,而不是满足于完善旧的“先验” — David 9

量子计算机和其它人类工具一样,只是帮助人们探索未见的新“先验”。因为第一期的量子计算QNN入门反响热烈,所以David打算在这里补充第二期。并回答一些前沿探索的关键性问题:

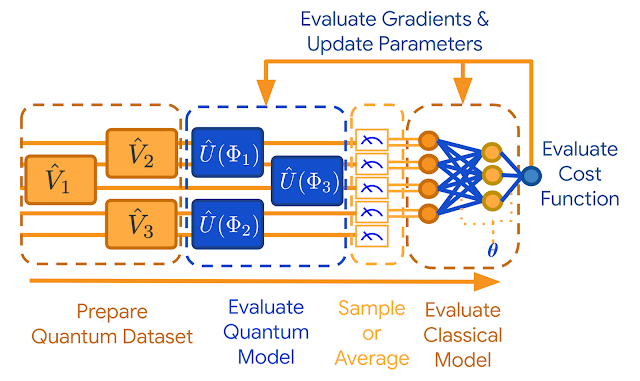

用一句话概括,TFQ(TensorFlow Quantum)是将Cirq与TensorFlow集成在一起的框架。TensorFlow是包装ml或深度学习算法的上层框架。而Cirq就更接近量子计算机设备操作,包括各种常见门逻辑,线路(Circuits)设计,支持不同结构的量子设备(google的Xmon量子设备是网状qubits)。

本质上,TFQ模型的目的是把量子线路(Circuits)嵌入到普通深度学习(机器学习)模型中,让量子线路编码经典深度学习(机器学习)的信息(下图蓝框部分):

即,制定一些量子线路操作,并对输入量子的量子间“去纠缠”,然后就可以编码经典世界中的信息。详细了解可以看看我们第一期内容。

NISQ和Cluster State是目前量子计算领域的主流概念。

叠加与纠缠的普遍存在, 继续阅读量子卷积神经网络QCNN,TensorFlow Quantum(TFQ)和近期量子计算的疑问总结和例子,David 9量子计算系列#2