如果大脑中的每个神经元都代表一些训练参数,那么,我们在不断的学习过程中,现有的神经元够用吗?大脑是如何优化参数效率的? — David 9

这届CVPR上的两篇最佳论文中, David 9更欣赏康奈尔大学和清华大学的密集连接卷积网络DenseNet(Densely Connected Convolutional Networks) , 内容有料,工作踏实 !我们在之前文章就提到,模型泛化能力的提高不是一些普通的Tricks决定的,更多地来源于模型本身的结构。

CNN发展至今,人们从热衷于探索隐式正则方法(Dropout, Batch normalization等等),到现在开始逐渐关注模型本身结构的创新。这是一个好现象。

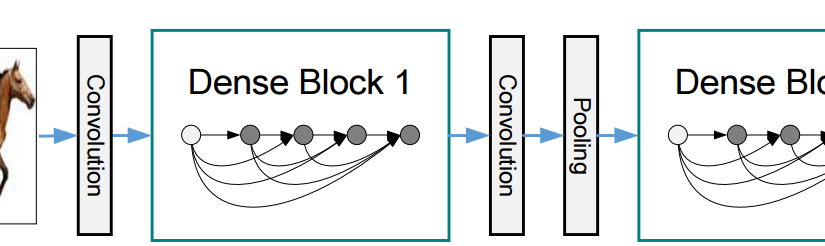

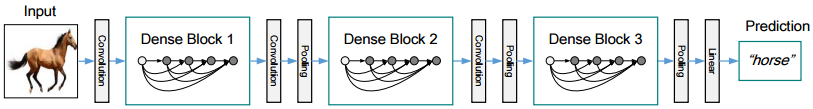

密集连接卷积网络DenseNet正是试图把跳层连接做到极致的一种结构创新:

跳层连接方法是对中间层输出特征图信息的探索,之前的ResNets和Highway Networks都曾使用,把前层的输出特征图信息直接传递到后面的一些层,可以有效地提高信息传递效率和信息复用效率。

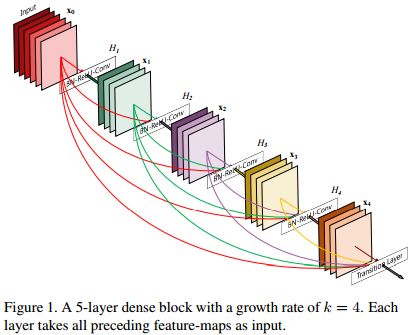

上图的密集连接模块尝试把跳层连接用到极致,每一层的输入都是由前面各层的输出合成的。

论文中也给出了公式化的解释,假设每一层 l 最后的非线性操作是如下表达式:

![]() 这个非线性操作可以是Conv,Batch Normalization (BN),ReLU,pooling 等等。

这个非线性操作可以是Conv,Batch Normalization (BN),ReLU,pooling 等等。

而每一层的输出是:

对于ResNets来说,每一层的输出只是当前输出叠加上一层输出的结果:

当然上图是相邻两次才跳一次的。

而密集连接卷积网络模块中,是每一层都尽可能地往前面的层跳跃:

用公式描述即:

当前层的输入是所有之前各层的输出叠加。

这样丰富的叠加虽然能增加各层之间的信息传递和信息复用,同时存在一个很棘手的问题,就是:特征图(信息)过多。试想如果没有上述图2中的密集块的分离,最后一层的输入特征图实在是太多了 !

DenseNet特意在每层输出控制卷积次数和输出特征。另外用了1*1的卷积的Trick对大量的输入特征图进行特征降维 (参考文献4, 5) 。David 9猜测1*1的卷积采用了类似交叉通道的降维方法,使得大量的特征图通道可以减少下来,才能进行后续的3*3卷积,提高计算效率并减少信息损失。

(参考文献3)对大量的特征图使用不同的1*1卷积,可以试图把各个特征图中的有用信息都收集起来,并降低特征图数量, 这是由人类视觉角质启发而来的灵感:

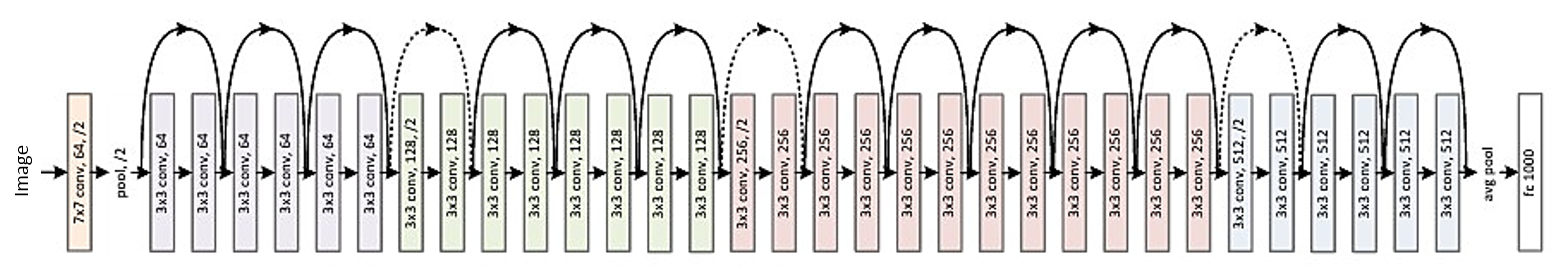

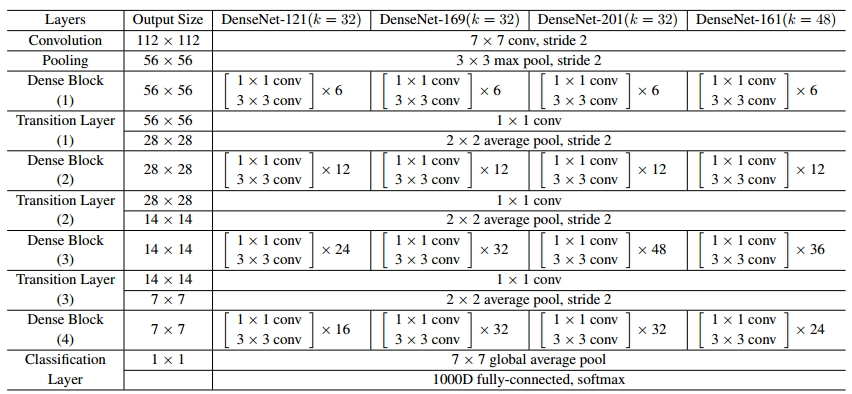

因此,1*1卷积可以看做一种“各个特征图之间的pooling方法”。总之,1*1卷积使得深度网络不至于往 “宽” 的方向走,而是可以往“深”的方向发展,看一下训练ImageNet的DenseNet架构,我们或许可以更清楚:

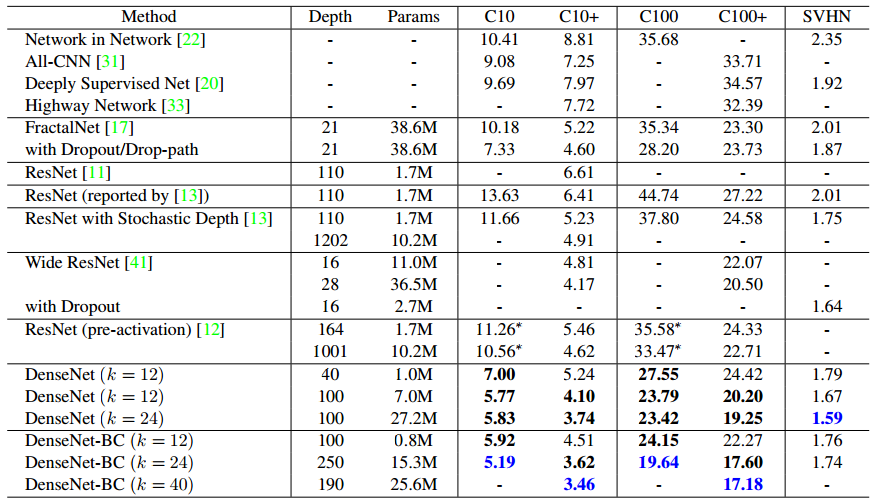

最后实验部分,我们看看论文给出的实验表:

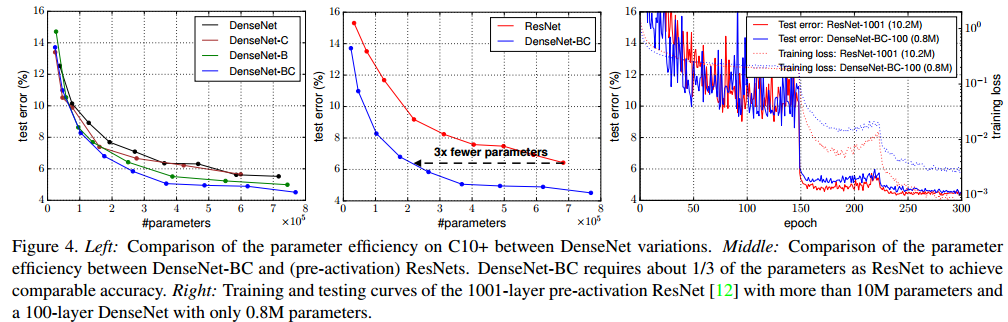

如上图,第4列以后都是错误率比较,我们看到准确率较之前的跳层连接的网络有了较大提升,有意思的是,通过第3列的训练参数的比较,我们可以发现DenseNet有了较大的效率提升(密集连接的信息传递和复用起到了一定效果)。我们使用较少的参数,也能训练出更好的网络。

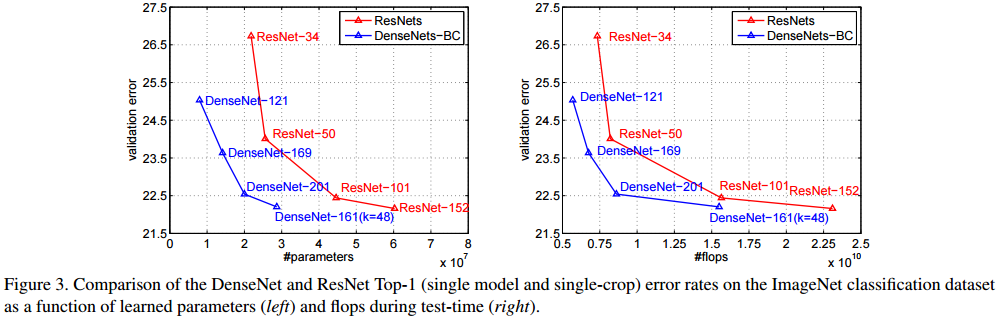

下面ResNets与DenseNet的比较,更是证明使用较少参数(左),以及较少的浮点运算次数(右),我们能够通过DenseNet获得同样的准确率:

David 9 相信,DenseNet参数效率的提升仅仅是人们认识深度学习参数数量和学习效率关系的开始,其中还有很多规律有待挖掘。

参考文献:

- https://arxiv.org/abs/1608.06993

- https://github.com/liuzhuang13/DenseNet

- http://iamaaditya.github.io/2016/03/one-by-one-convolution/

- http://www.cv-foundation.org/openaccess/content_cvpr_2016/papers/Szegedy_Rethinking_the_Inception_CVPR_2016_paper.pdf

- http://www.cv-foundation.org/openaccess/content_cvpr_2016/html/He_Deep_Residual_Learning_CVPR_2016_paper.html

本文采用署名 – 非商业性使用 – 禁止演绎 3.0 中国大陆许可协议进行许可。著作权属于“David 9的博客”原创,如需转载,请联系微信: david9ml,或邮箱:yanchao727@gmail.com

或直接扫二维码:

David 9

Latest posts by David 9 (see all)

- 修订特征已经变得切实可行, “特征矫正工程”是否会成为潮流? - 27 3 月, 2024

- 量子计算系列#2 : 量子机器学习与量子深度学习补充资料,QML,QeML,QaML - 29 2 月, 2024

- “现象意识”#2:用白盒的视角研究意识和大脑,会是什么景象?微意识,主体感,超心智,意识中层理论 - 16 2 月, 2024