“One can be the master of what one does, but never of what one feels.” ― Gustave Flaubert

一个人可以熟练掌控他干的事,但TA永远不能掌控自己的感受 —— 古斯塔夫·福樓拜

语言学中有一个著名的“可理解的输入”假说,当人学习除母语以外第二语言时,只有当习得者充分理解语言环境的意义(而不是形式模式),并且有足够的输入(环境)的量时,自然就可以学习。这就解释了为什么有些成人即使在国外很多年还是不能很好地掌握第二语言,而小孩则往往相反他们掌握的更快。用david的话说就是,两者的内在模型天差地别,孩子更愿意关注“意义”并且模型更灵活没有固化下来,

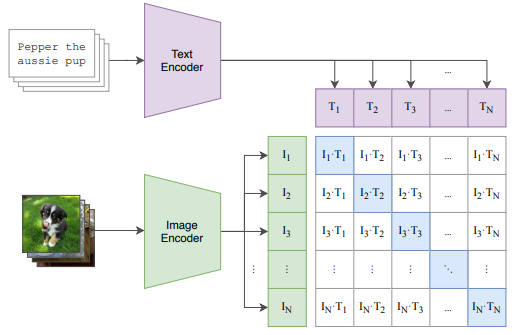

这么看来,目前的大规模语言系统(Bert,GPT等)是相当肤浅的,它们跳过了“理解”这一步。

这里还要强调的是,可理解的“输入”事实上是多模态的,学习语言不仅仅是声音输入,还有周围语境,对话者表情,自身在这个时刻的感受,等等等等……

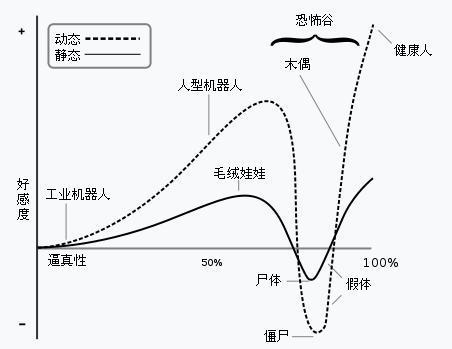

人类把所有这些复杂的感知融合,过滤,以自己的方式进行理解后,输出了语言。很难否认感知(感受)对人类智能有重要的作用,但是感知(感受)在人类智能中的运作方式,和计算机或者新物种是应该一样的吗?这个问题先保留给大家自己思考。

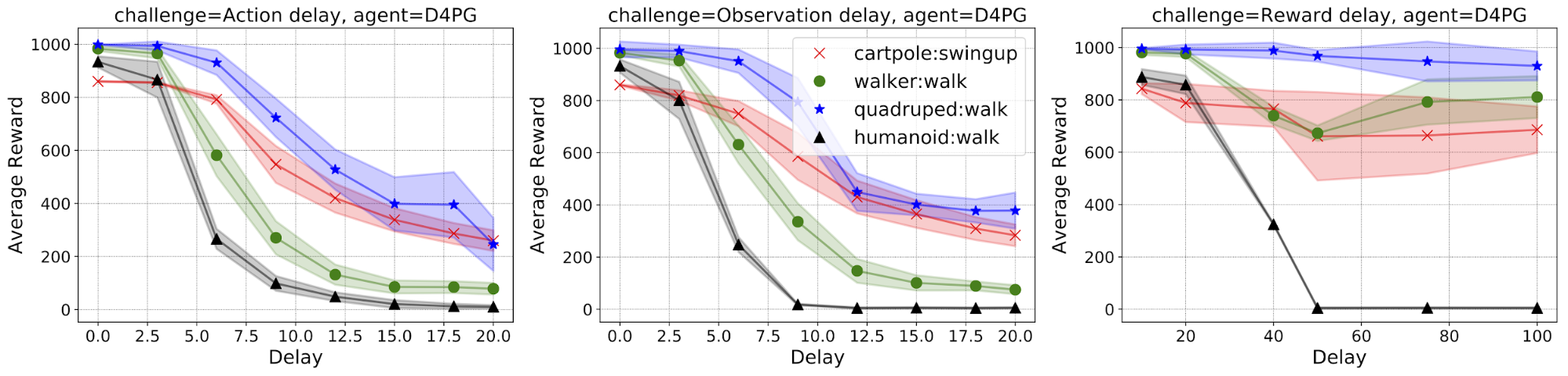

目前可以看到的是,对于机器的学习,“肤浅感知”是比较有效的, 继续阅读感知融合?感知迁移?感知涌现?感知的未来?