背景:

总览

机器学习方法在生产、生活和科研中有着广泛应用,而集成学习则是机器学习的热门方向之一。

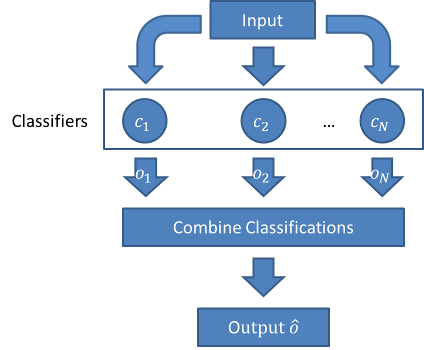

集成学习是使用一系列学习器进行学习,以某种规则把各个学习结果进行整合,从而获得比基学习器有更好学习效果的集成学习器.

今天, 我们在分析讨论集成学习和多类集成学习的同时, 提出目前多类集成学习的一些问题, 供大家参考。

集成学习图例

研究现状

理论丰富

二类集成学习已有较成熟理论基础。多类集成理论基于二类集成。

国际成果:

Bagging (Leo Breiman, 1994,Technical Report No. 421.)

Boosting (Schapire, Robert E,1990 ,“The Strength of WeakLearnability”. Machine Learning (Boston, MA: Kluwer Academic Publishers)

AdaBoost (Yoav Freund and Robert Schapire,2003)

AdaBoost.MH, SAMME, PIBoost, GentleBoost, AdaCost

国内成果:

南大周志华等人提出选择性集成理论,于2001年在国际人工智能

顶级会议IJCAI上发表。另周志华等人提出了二次学习的思想,将集成学习用作预处理,在IEEE Trans. Information Technology in Biomedicine(2003)上发表。

应用广泛

- 机器视觉:医疗诊断 、游戏等

- 数据挖掘:推荐系统、商业决策等

- 模式识别:语音识别、人脸识别、手写识别等

研究意义:为何选择多类集成学习

多类集成与二类集成对比,研究空间大,应用范围广,训练难度更高

| 二类集成学习 | 多类集成学习 | |

| 不确定性和复杂性 | 低 | 较高 |

| 成熟度 | 高 | 较低 |

| 应用范围 | 较窄(仅限二类) | 较广 |

| 公认成熟框架 | Adaboost | 无 |

| 类别敏感与否 | 否 | 是 |

研究内容:解决问题

多类集成学习存在的问题:

1.多类集成学习普遍缺乏对类别权重的考虑,即使平衡数据集也存在各个类别训练不平衡的问题。

2.多类集成学习并不成熟,在平衡或非平衡,离散或连续,以及一些半监督和代价敏感特定应用中,还处于探索阶段。

针对多类集成学习存在的问题,总结如下研究内容:

- 将二类集成学习扩展到多类集成学习, 增加算法可扩展性(基于AdaBoost.SAMME算法改进)

- 把类别权重考虑到多类集成学习中,提高预测精度和泛化能力(在高斯数据集,UCI数据集和KDD数据集上做比较和研究)

- 把结合类别权重的多类集成学习应用到入侵检测的多类预测分类问题(改进算法有效提高预测精度,调整模型预测边界)

- 使用可变步长策略优化多类集成学习模型(算法训练优化)

这就是我目前的一些想法, 如果对细节和详细算法有兴趣, 请参考下面的PPT,或者随时联系我的私人微信yanchao 727727.

David 9

Latest posts by David 9 (see all)

- 修订特征已经变得切实可行, “特征矫正工程”是否会成为潮流? - 27 3 月, 2024

- 量子计算系列#2 : 量子机器学习与量子深度学习补充资料,QML,QeML,QaML - 29 2 月, 2024

- “现象意识”#2:用白盒的视角研究意识和大脑,会是什么景象?微意识,主体感,超心智,意识中层理论 - 16 2 月, 2024

《#3 集成学习–机器学习中的群策群力 !》上有1条评论