深度学习似乎进入了“泛模型”阶段,同一个问题可以用不同深度学习结构解决,但是没有人可以证明哪个模型一定最好 — David 9

最近读到文章说“TCN(时间卷积网络)将取代RNN成为NLP预测领域王者”。一方面David 9 想为RNN抱不平,请大家别过于迷信CNN,毕竟只是一种特征提取方法,不必神话它(想想当年有人认为SVM可以解决所有建模问题)。

另一方面,可以感受到深度学习进入了“泛模型”的阶段。模型的结构创新没有衰退的趋势,而这些创新不出意料很快会被其他模型超越。这些“超越”都是实验与经验上的“超越“,没有SVM这样扎实的理论。

回顾历史可以发现,广义的计算机”模型“一直在”向上”做更灵活的事情。

ML时代那些机器学习”模型“(SVM,随机森林)一般只做最后的分类、聚类或回归;现在深度学习时代“模型”(以CNN、RNN为主)把特征提取的工作也一并做掉了。可以预见,未来物联网IOT发展到一定阶段,我们需要更复杂“模型”去自动收集数据,具体是什么形式的“模型”我们可以拭目以待。

言归正传,今天David 9 要把TCN(时间卷积网络,CMU的研究总结)这个“坑”给填了。其实TCN只是一维卷积变形之后在时序问题上变得适用(以前David 9也讲过一维卷积):

for Sequence Modeling

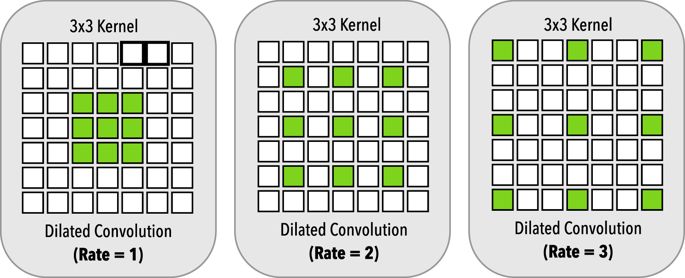

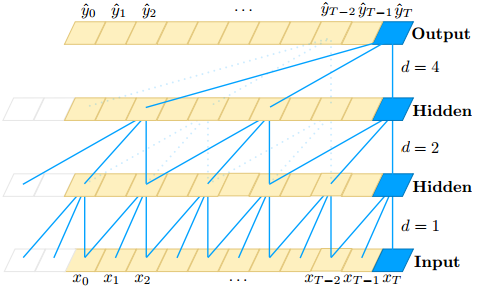

仔细观察就可以发现,TCN的卷积和普通1D卷积最大的不同就是用了扩张卷积(dilated convolutions),越到上层,卷积窗口越大,而卷积窗口中的“空孔”越多。

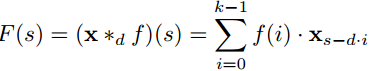

上式是扩展卷积操作的式子,其中d是扩展系数(即评价“空孔”的多少)。 继续阅读时间卷积网络(TCN) 总结:时序模型不再是递归网络(RNN) 的天下,但作为信息粗暴提取的一种方法,请不要神话CNN !