虚拟化技术牺牲硬件开销和性能,换来软件功能的灵活性;深度模型也类似,如果把网络结构参数化,得到的模型更灵活易控,但是计算效率并不高。 — David 9

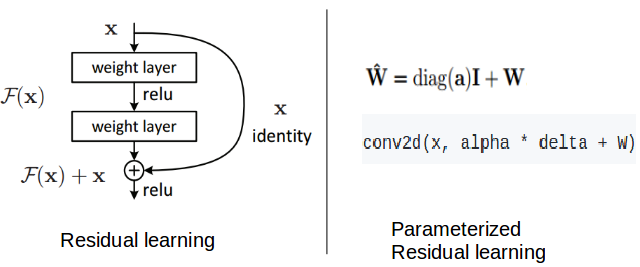

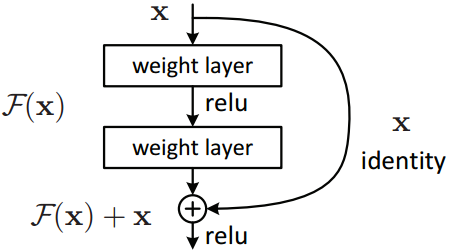

近年来深度网络结构的创新层出不穷:残差网络,Inception 系列, Unet,等等。。微软的残差网络ResNet就是经典的跳层连接(skip-connection):

上一层的特征图x直接与卷积后的F(x)对齐加和,变为F(x)+x (特征图数量不够可用0特征补齐,特征图大小不一可用带步长卷积做下采样)。这样在每层特征图中添加上一层的特征信息,可使网络更深,加快反馈与收敛。

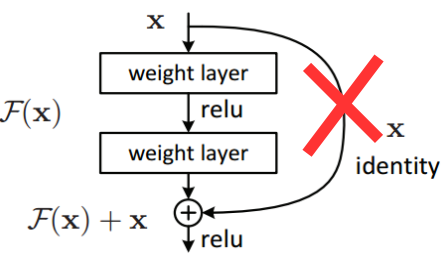

但是ResNet也有明显的缺陷:我们无法证明把每一层特征图硬连接到下一层都是有用的;另外实验证明把ResNet变“深”,不如把ResNet变“宽”, 即,到了一定深度,加深网络已经无法使ResNet准确度提升了(还不如把网络层像Inception那样变宽)。

于是,DiracNets试图去掉固定的跳层连接,试图用参数化的方法代替跳层连接:

那么问题来了,我们怎么参数化这个被删除的跳层连接? 继续阅读CVPR2018抢先看,DiracNets:无需跳层连接,训练更深神经网络,结构参数化与Dirac参数化的ResNet

那么问题来了,我们怎么参数化这个被删除的跳层连接? 继续阅读CVPR2018抢先看,DiracNets:无需跳层连接,训练更深神经网络,结构参数化与Dirac参数化的ResNet